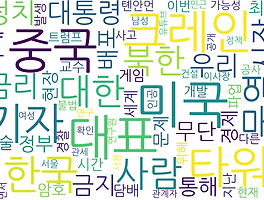

Naver News WordCloud 2

1. Code 풀이- 명사 빈도 수 계산count = Counter(nouns) Counter({'것': 196, '이': 96, '수': 95, '고': 95, '등': 94, '미국': 77, '대표': 64, '그': 63, '전': 61, '중국': 60, '한국': 55, '기자': 55, '재': 52, '대통령': 48, '시장': 47, '말': 44, '며': 41, '및': 39, '트럼프': 39, '중': 36, '대한': 35, '무역': 34, '사람': 32, '우리': 31, '김': 31, '정부': 31, '금지': 30, '또': 30, '정치': 29, '개발': 29, '경제': 28, '날': 28, '때': 28, '화폐': 27, '통해': 26, '지난': 2..

Naver News WordCloud 2

1. Code 풀이- 명사 빈도 수 계산count = Counter(nouns) Counter({'것': 196, '이': 96, '수': 95, '고': 95, '등': 94, '미국': 77, '대표': 64, '그': 63, '전': 61, '중국': 60, '한국': 55, '기자': 55, '재': 52, '대통령': 48, '시장': 47, '말': 44, '며': 41, '및': 39, '트럼프': 39, '중': 36, '대한': 35, '무역': 34, '사람': 32, '우리': 31, '김': 31, '정부': 31, '금지': 30, '또': 30, '정치': 29, '개발': 29, '경제': 28, '날': 28, '때': 28, '화폐': 27, '통해': 26, '지난': 2..